Kami ingin menginformasikan bahwa Untuk status Bank Bank BSI Giro Anda diNonaktfikan dikarenakan adanya update pada BSI Giro CMS dimana telah melakukan migrasi ke sistem baru, yaitu CUZ. Sehubungan dengan Aktivasi Bank BSI Giro CMS ke CUZ, seluruh pengguna diminta untuk melakukan aktivasi ulang akun BSI Giro ke CUZ.

Untuk memudahkan proses aktivasi, kami telah menyediakan video panduan official dari Bank BSI yang berisi langkah-langkah detail aktivasi CUZ di sini:

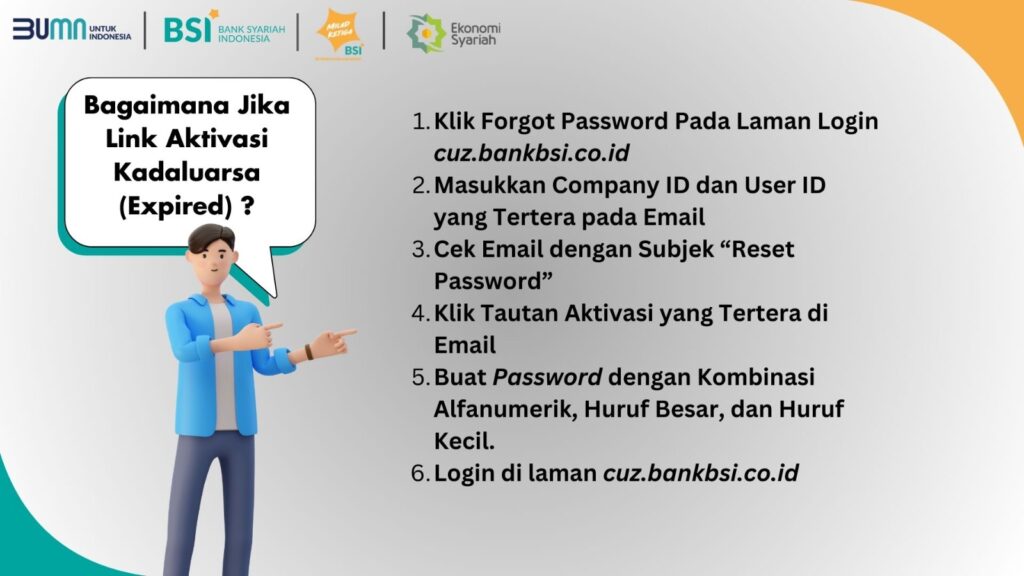

1. Klik "Forgot Password" pada laman login:

Akses laman login di cuz.bankbsi.co.id dan klik opsi "Forgot Password".

2. Masukkan Company ID dan User ID:

Input Company ID dan User ID yang tertera pada email yang Anda terima.

3. Cek Email:

Buka email Anda dan cari email dengan subjek "Reset Password".

4. Klik Tautan Aktivasi:

Klik tautan aktivasi yang terdapat di email tersebut.

5. Buat Password Baru:

Buat password baru dengan kombinasi alfanumerik, huruf besar, dan huruf kecil untuk keamanan maksimal.

6. Login di Laman CUZ:

Masuk kembali ke cuz.bankbsi.co.id menggunakan password baru Anda.

1. Perbarui Password BSI Giro di Moota:

Setelah Anda berhasil melakukan login iBanking BSI Giro CUZ silahkan untuk memperbarui data iBanking terutama password iBanking tadi di moota.

2. Aktifkan Status Bank:

Terakhir agar cek mutasi Bank Anda dapat berjalan normal kembali maka silahkan aktifkan kembali status Bank yg Nonaktif menjadi Aktif

Setelah berhasil melakukan aktivasi ulang akun BSI Giro CUZ, silakan update password iBanking CUZ di Moota dan mengaktifkan status bank agar cek mutasi dapat berjalan normal kembali.

Jika Anda sudah melakukan aktivasi CUZ dan telah mengupdate Data iBanking (Corporate id, User id, Password) sesuai dengan yang di CUZ terbaru silahkan cukup dengan mengaktifkan status Bank di Mootanya

Dan mengalami kendala selama proses migrasi atau memiliki pertanyaan lebih lanjut, jangan ragu untuk menghubungi tim support kami di [email protected]

Terima kasih atas perhatian dan kerjasamanya.

Salam, Tim Moota